Com o avanço exponencialmente mais rápido a cada dia da inteligência artificial (leia-se: cada vez mais ocupações até hoje desempenhadas exclusiva ou predominantemente por humanos vem sendo total ou parcialmente automatizadas), todas as profissões conhecidas tendem a desaparecer. Umas antes, outras depois (o famoso estudo de Oxford). É só uma questão de tempo. E com a morte das profissões, está decretado o fim do trabalho. Podemos até duvidar que isto aconteça durante nossas vidas. Mas, queiramos ou não, testemunhemos ou não, se trata de um desfecho histórico inevitável.

Por exemplo. Ainda que a fotografia já tenha sido uma profissão com nichos bem específicos de atuação profissional (jornalismo, publicidade, perícia, etc.), é difícil acreditar que hoje, com todas as facilidades embutidas em telefones celulares, seja mais do que uma ocupação recreativa ou, no máximo, artística. Mas a própria figura do artista profissional, que comercializa o que produz para o consumo de meros espectadores, tende a desaparecer com a universalização da criação artística, hoje privilégio de alguns, doravante ao alcance de toda a população.

Este quadro é demasiado sombrio ? Soo pessimista ? Não acho. Primeiro, por que já está acontecendo. Se já é difícil, senão impossível, se viver de fotografia, o mesmo acontece com a música. Como evitar o encolhimento das profissões musicais quando fica cada vez mais fácil a qualquer um criar e produzir sua própria música ? Isto sem falar no enorme manancial de música do passado que pode ser garimpada a qualquer instante a um custo que tende ao zero. E a produção textual, antes um privilégio de indivíduos mais instruídos, emprega cada vez menos gente, como vimos no post anterior.

Não me entendam mal: falo do fim das profissões, e não das ocupações ! É claro que as últimas continuarão (oxalá !) existindo; só não poderemos mais contar com elas para garantir a subsistência.

O futuro é lúdico. Ao menos se a economia se transformar radicalmente e uma revolução moral permitir que a humanidade deixe de culpar a si própria (e aos outros) pelo ócio. Mas voltemos à música, objeto deste texto.

Por mais abomináveis que possam ser, rótulos também são bem úteis por nos ajudarem a categorizar. Aí incluídos os gêneros musicais. Se a música erudita ambiciona a posteridade, para além da morte do compositor, o pop visa o lucro imediato, desfrutável ainda em vida. Sei, são generalizações um tanto apressadas. É claro que o melhor pop, graças ao culto dos fãs, sobrevive a seus criadores. E a indústria bem que tentou fazer da música clássica um produto. Mas, via de regra, pop é coisa de gente viva e música clássica, de gente morta. E não me venham, por favor, com exceções, que existem, e muitas. Por que minha generalização, por mais tosca que seja, se aplica a uma amostra estatisticamente neutra, a saber, o que mais se ouve no rádio e em concertos.

Mas e o jazz ? Parece correr em banda própria, paralelamente à música conforme vista pela indústria. É como se, nela, a música, pop ou erudita, fosse, de certo modo, domesticada. O jazz, não: permanece uma manifestação selvagem. A maior prova disto é que seus produtores, ao invés de tentar ajustar a música a demandas de mercado, na maior parte das vezes se limitam a capturá-la (uma amostra, como veremos adiante).

Sim, bem que a indústria tentou domar o jazz e, por um breve instante, até conseguiu. Kind of Blue foi um campeão de vendas tão expressivo como um hit pop. Mas já estou, aqui, a falar da exceção. Todo jazzófilo sabe que, por mais discos de músicos icônicos que tenha colecionado, o jazz enquanto risco (a alma de toda improvisação, alicerce do jazz) só acontece em apresentações ao vivo, quase sempre para audiências minúsculas.

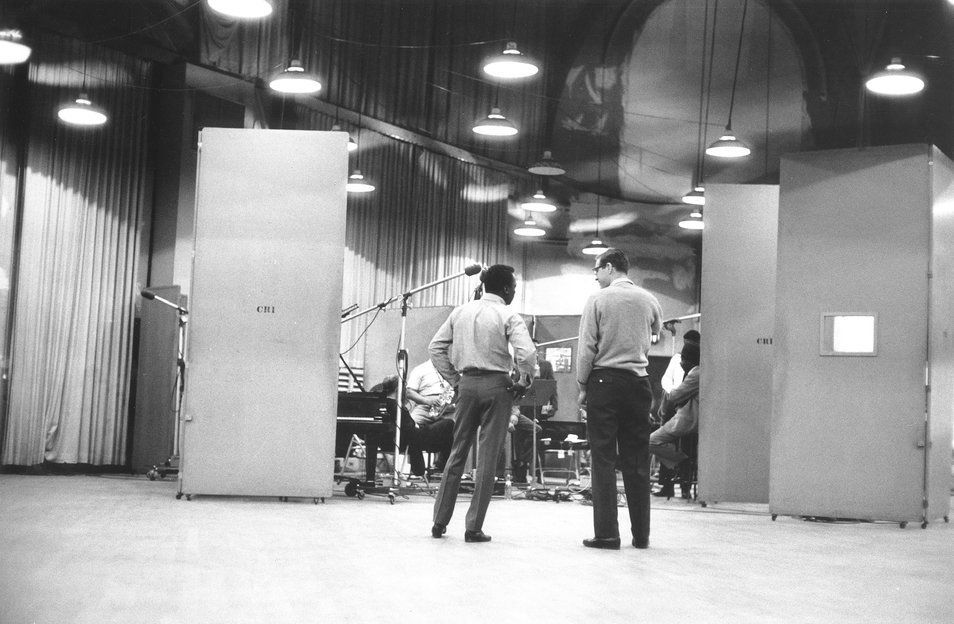

Não toco jazz. Tenho profunda inveja de quem sabe e se atreve a improvisar. Mas posso ter ideia da estranheza com que um músico de jazz deve perceber um produtor de gravações do gênero. Ora, todo disco de jazz é não mais do que uma pálida amostra de toda a gama de possibilidades que uma performance poderia ter assumido. É justo isto que o torna tão interessante.

Continuo, mesmo assim, com a ideia de que o produtor de discos de jazz é um profissional condenado ao fracasso por tentar, repetidamente (fez, na verdade, disto uma profissão), capturar num meio reproduzível algo que jamais acontecerá do mesmo jeito no tempo. Por isto mesmo, sou enormemente grato aos bons produtores de gravações de jazz, por quem nutro profundo respeito.

Mas por que o jazz é, afinal, a música do futuro ? Elementar, meu caro Watson: por que é a música do aqui e do agora. Enquanto toca, um improvisador exponencial não está preocupado com a remuneração que poderá auferir da performance, nem tampouco com o que legará à posteridade. Naquele momento, só está preocupado em superar a si próprio, ao que entregou na gig anterior. Neste sentido, é a música mais honesta que conheço. Remuneração e legado interessam, é claro, mas são meramente circunstanciais.